„Immersive“ gehört in der Audiowelt wohl zur „invasiven Spezies“ – es überwuchert alle differenzierteren Beschreibungen der technischen Umsetzung eines alten Anliegens der Theater-, Musik- und Kunstwelt: das Publikum in eine andere Welt als die Reale mitzunehmen. Welche grundsätzlichen Ansätze existieren für Säle und Veranstaltungen, um Quellen und Raum in 3D anders zu erfahren, als sie tatsächlich existieren?

(Bild: Midjourney/Detlef Hoepfner)

(Bild: Midjourney/Detlef Hoepfner)

Inhalt dieses Grundlagen-Artikels:

- 3D-Audio

- Wellenfeldsynthese – theoretisch

- Praxistauglich objektbasiert

- Live

- 3D für überall

- Völlig andere Aufgabe: Raumsimulation

- Methode 1: In-Line als Klangeffekt

- Regenerativ: Reflexionsmuster verändern

- Hybride Realität: von allem etwas

- Beispiele: Raum ohne Raum

- Richtungsrichtig hören

- Variable Raumakustik

- Auf der Bühne

- Sprache unterstützen

- Mehr als 3D-Effekte

- L-ISA für die Mainstage der LEaT con

- Planungsschritte und Aufwand

Zwei Fragestellungen sind grundsätzlich zu unterscheiden: Systeme, die eine freie Positionierung der Quellen unabhängig von ihrem eigentlichen Standort zulassen – ich nennen das mal 3D-Audio. Und Lösungen, die den Raum akustisch anders gestalten, als er ist. Hier soll dies als Raumsimulation bezeichnet werden. Beide Ansätze blicken auf eine lange Historie zurück, und entsprechend viele Beispiele für Anwendungsmöglichkeiten gibt es.

3D-Audio

Die Wiedergabe über Lautsprecher brachte immer schon das Problem mit sich, dass Quellen vom Publikum nicht automatisch auch da lokalisiert werden, wo sie eigentlich „hingehören“. Mit Lautsprechern rechts und links der Bühne gab es aber mithilfe des PAN-Reglers auf dem Mischpult eine Möglichkeit, ein gewisse realistische Breitenstaffelung zu bekommen – zumindest für einen Teil des Publikums. Delays könnten für eine Erweiterung und gewisse Tiefenstaffelung sorgen. Mit einem Center-Lautsprecher ließ sich zudem schon mal ein in der Mitte stehender Sprecher oder Sänger für alle Zuschauer an derselben Position positionieren. Denn da lag das Problem mit Stereo: Die durch Zeit- und Richtungsinformation bestimmte Lokalisierung der Quelle aus der Mitte funktioniert bei gleichem Signal aus den linken und rechten Lautsprechern nur in einem bestimmten Bereich der Publikumsfläche.

Um nun für alle im Saal dieselbe Lokalisierung sicherzustellen, muss entweder der Lautsprecher an der Quelle stehen (legendär ist hier die ‚Wall of Sound‘ 1973 von Greatful Dead, kleine Musiker-Setups mit Zeilenlautsprechern auf der Bühne verfolgen ein ähnliches Ziel) oder den Ohren auf andere Weise die passenden Zeit- und Richtungsinformationen gegeben werden.

Wellenfeldsynthese – theoretisch

Der historische Ansatz zur Positionierung einer virtuellen Quelle im Raum basiert auf dem im 17. Jahrhundert von dem niederländischen Physiker Huygens formulierten Prinzip, dass jeder Punkt einer Wellenfront als Ausgangspunkt einer neuen Welle dargestellt werden kann. Jede Wellenfront kann so als eine unendliche Anzahl von kleinen Quellen gesehen werden, die zusammen die nächste Wellenfront bilden. Für den Zuhörer ist nicht zu unterscheiden, ob die bei ihm ankommende Wellenfront von einer einzigen Quelle oder von einzelnen kleinen Quellen (z.B. nah nebeneinander installierten Lautsprechern) stammt, wenn die Wellenfront, die beide erzeugen, identisch ist. Die mathematischen Berechnungen, wie sich die einzelnen kleinen Quellen verhalten müssen, damit sie die entsprechende Wellenfront bilden, beruhen auf den Theorien von Kirchhoff und Rayleigh. Vom Prinzip her wird mit den mathematischen Gleichungen ein Signal berechnet, das am Punkt des WFS-Lautsprechers dem der virtuellen Quelle entspricht. Nachbilden lassen sich virtuelle Punktquellen mit Positionen vor oder hinter den WFS-Lautsprechern und ebene Wellen.

Nun braucht so ein System sehr viele Lautsprecher schon für eine zweidimensionale Installation, da kleine Quellen in einem lückenlosen Band an den Wänden installiert werden. In einer Installation in einem Hörsaal in Berlin 2007 waren es 2700 Lautsprecher! Die freie Positionierung von Quellen im Raum inklusive richtungsrichtiger Ortung recht unabhängig vom Standpunkt des Zuhörers gelingt mit so einem System gut. Aber eine solche Anlage ist natürlich für Konzert- oder Theatersäle nicht praxistauglich.

Praxistauglich objektbasiert

Wie man mit weniger Lautsprechern ein Objekt platzieren kann, daran hat z.B. das Fraunhofer IDTM viel Forschungs- und Entwicklungsarbeit geleistet. Bereits 2004 bot die Ausgründung Iosono (später Teil von Barco) eine praxisnahe Lösung an. Ein Iosono-Prozessor kam beispielsweise bei Kraftwerk schon 2013 live zum Einsatz. Auf den Fraunhofer-Entwicklungen basieren z.B. auch das Spatial Sound Wave, kurz SSW (später Astro Spatial Audio der niederländischen Firma Vanmunster BV).

Die Bezeichnung „objektbasiert“ beschreibt dagegen die Arbeitsweise: Der Nutzer hat eine Software-Oberfläche, auf der er Objekte definiert, die eine bestimmte Position haben oder sich in bestimmter Weise durch den Raum bewegen. Das System berechnet aus der Kenntnis der einzelnen Lautsprecherpositionen, wie mit ihnen am besten die entsprechende Wellenfront geformt werden kann, damit die Quelle von der gewünschten Position gehört wird. Wie differenziert die Platzierung und Wahrnehmung unabhängig von der Hörerposition möglich ist, hängt davon ab, wie nah die Lautsprecher gesetzt sind. „Es gibt so eine Erfahrungsregel, dass der Abstand der Lautsprecher zueinander nicht grösser als der Abstand zu den Zuhörern sein sollte“, erläuterte schon beim Besuch des Opernhauses Zürich 2016 der Fraunhofer-Mitarbeiter René Rodigast. „Es hängt aber von der Auflösung ab, die ich möchte. Wenn ich bei einer Live-Anwendung einen Abstand von 10 Metern zwischen den Lautsprechern habe, dann erziele ich ja immer noch einen räumlichen Effekt, auch wenn die Lokalisation nicht mehr so präzise ist.“

3D-Audio ist dabei bei Veranstaltungen nicht nur Spielerei für spannende Effekte: Auf der Seebühne in Bregenz ist das richtungsrichtige Hören der Akteure die Grundlage, um den doch recht kleinen Sängern auf der riesigen Bühne folgen zu können.

Live

Auch für Konzerte können sich neue Möglichkeiten eröffnen, die Quellen für alle an der passenden Stelle zu positionieren – also eine Gitarre links auf der Bühne hören auch alle links – und nicht je nach Sitzposition in der Mitte, rechts oder (bei extremer Pan-Einstellung auf dem Mischpult) gar nicht. Dies ist beispielsweise eine der Funktionen im d&b-Modul En-Scene der Soundscape Software im DS 100: Mit mehreren Line-Arrays über die Bühnenbreite verteilt kann nicht nur die Lokalisation der Bandmitglieder richtungsrichtig gelingen. Die räumliche Verteilung der Quellen hilft dem Hörer im Idealfall auch, die Quellen differenzierter und klarer zu hören.

3D für überall

Für Film und Fernsehen ist die „Effekthascherei“ natürlich besonders wichtig. Schon in 5.1. oder 7.1. Surround bereicherten räumliche Effekte mit ihren Hubschrauberflügen quer durch den Saal das Filmvergnügen. Mit Formaten wie Dolby Atmos geht das sogar mit dem Smartphone: Über den Kopfhörer werden die Richtungsinformationen mittels der HRTFs (Head Related Transfer Function) hinzugefügt. Vielleicht sogar auf die eigenen Ohrphysiologie zugeschnitten, also mit personalisierte PHRTFs. Zu Hause hängt es neben den Algorithmen dann auch vom Raum und den Lautsprechern ab, inwieweit es gelingt, ein Objekt, dass von vorne aus dem Lautsprecher wiedergeben wird, von hinten zu hören.

In einer zertifizierten Dolby Atmos-Regie nutzt der Tonschaffende immer noch seine eigenen Ohren. Eine Vielzahl von Lautsprechern an den Seiten und an der Decke sorgen für die Voraussetzungen zur Positionierung der Klangobjekte. Dabei definiert Dolby, welche Raumgröße, Raumakustik, Lautsprecherpositionen und Typen zu nutzen sind.

Völlig andere Aufgabe: Raumsimulation

Einen Raum akustisch zu erzeugen, den es gar nicht in dieser Form gibt, kann z.B. bei einer Open-Air Veranstaltung mit klassischer Instrumentierung gewünscht sein, bei der zum Klangerlebnis auch eine gewisse Einhüllung in das Klanggeschehen erwartet wird. Die Intentionen können auch in einer virtuellen Beeinflussung der Raumakustik oder bestimmter akustischen Bedingungen liegen. Es kann darum gehen, auf der Bühne für ein Orchester bessere Hörbedingungen zu schaffen, durch die Verstärkung der ersten Reflexionen Sprache lauter zu machen oder einen Saal durch eine virtuelle Verlängerung der Nachhallzeit für verschiedene Nutzungen zu optimieren.

Dazu werden Lautsprecher seitlich, hinter und für die dritte Dimension auch oberhalb des Publikums platziert. In welcher Anzahl und Positionierung, hängt vom System ab. Es sind aber in jedem Falle wesentlich mehr und verteilter als in herkömmlichen Lautsprechersystemen. Wiedergegeben werden Signale, die von Mikrofonen auf der Bühne, im Saal oder beidem aufgenommen und dann in einem Prozessor bearbeitet werden. Hierfür existieren zwei unterschiedliche Konzepte: In-Line oder Regenerativ.

Methode 1: In-Line als Klangeffekt

Bei der In-Line-Methode wird der Direktschall aufgenommen und bearbeitet, z.B. mit der Impulsantwort eines Raumes „gefaltet“. So eine Faltung (in englisch Convolution) im Zeitbereich ist mathematisch eine nicht allzu aufwändige Multiplikation im Frequenzbereich. So gelingt es vielen Computer-Programmen, zum Beispiel einen Sprecher wahlweise in den Kölner Dom oder andere berühmte Räumlichkeiten zu versetzen. Es braucht nur zusätzlich zum Originalsignal die Impulsantwort aus dem Raum, in den man die Akteure versetzen möchte. Über Kopfhörer hört sich das Resultat der Faltung realistisch an.

Damit sich aber ein Saal durch die über Lautsprecher wiedergegeben Signale realistisch und ohne störende Artefakte wie eine andere Halle anhört, sind schon noch ein paar mehr Bearbeitungsschritte nötig. Durch die räumliche Trennung der Mikrofone zur Aufnahme des Direktschalls z.B. auf der Bühne und Lautsprecher im Zuschauerraum ist die Gefahr von Rückkopplungen nicht hoch. Ohne Mikrofone im Saal spielt aber weder der Saal selber noch die Geräuschkulisse durch die Zuschauer eine Rolle in dem Hallsignal, das über die Lautsprecher wiedergegeben wird. Es handelt sich also eher um einen Klangeffekt als darum, auf Basis von vorhandener Raumakustik und Klanggeschehen elektroakustisch das Reflexionsmuster dahingehend zu beeinflussen, dass der Hall im Raum länger wird.

Regenerativ: Reflexionsmuster verändern

Dies ist der Ansatz der regenerativen Methode: Mikrofone und Lautsprecher befinden sich im Diffusfeld eines Raumes. Die Mikrofone nehmen den Raumklang auf, dieser wird im System verstärkt und bearbeitet, über eine Matrix gemischt und an die Lautsprecher zurückgeben. Dabei wird die Schleifenverstärkung so gesetzt, dass kein Feedback entsteht. Damit aber dem Raum trotzdem hinreichend Energie zugeführt wird, um den Nachhall zu verändern, ohne dass es andererseits zu Rückkopplungen oder Verfärbungen kommt, ist eine umfangreiche Bearbeitung des Signals erforderlich. Als Beispiel für eine solche Bearbeitung soll hier die Arbeitsweise des VRAS – der Vorgänger des Constellation von Meyer Sound – in Grundzügen umrissen werden.

Grundsätzlich ist beim VRAS zwischen zwei Modulen zu unterscheiden: Reverb für den Nachhall und ER für die frühen Reflexionen (Early Reflections).

Vereinfacht dargestellt sorgt der Reverb für eine Verstärkung des Nachhalls. Das Klangbild des Nachhalls entsteht durch mehrere im Reverb einstellbare Parameter: Der Modus des sogenannten Unitary-Hallgeräts, die Dichte der Echos, der Anteil des Direktschalls, der Frequenzgang, das Verhältnis der Verzögerungszeiten der einzelnen Kanäle zueinander sind u.a. festzulegen. Die Justierung des Systems ist eine recht komplexe Angelegenheit. Schon bei der Auswahl und Positionierung der möglichst omnidirektionalen Lautsprecher und Mikrofone sind einige grundsätzliche Sachverhalte bezüglich des Abstands der Komponenten zueinander und zum Zuhörer zu beachten. Auch die Anzahl der Komponenten ist recht hoch: Für einen recht kleinen Saal mit in etwa 500m³ sind ca. 16 Lautsprecher und 16 Mikrofone notwendig. Im Kongresszentrum in Prag, wo das System bereits 2001 installiert war, kommen in dem 40.000m³ großen Saal 64 Lautsprecher und 24 Mikrofone zum Einsatz.

Das zweite Modul ER beeinflusst einen weiteren wichtigen Parameter für das Raumempfinden, die frühen Reflexionen. Mikrofone im Direktschallfeld der Quelle, z.B. der Bühne, nehmen den Direktschall auf. Die Lautsprecher im Nahfeld der Zuhörer, typischerweise an den Seitenwänden, geben die ebenfalls bearbeiteten und in einer Matrix gemischten Signale wieder. Durch das Kreuzen aller Eingangskanäle mit allen Ausgangskanälen produzieren die Lautsprecher eine Vielzahl kleiner Echos, die für den Zuhörer wie die Reflexionen von einer Wand wirken. Aber auch bevor die frühen Reflexionen natürlich klingen, ist eine ganze Anzahl von Parametern zu setzten, u.a. der Frequenzgang und die Delay-Zeiten, die so zu setzten sind, dass die Reflexionen nach dem Direktschall beim Zuhörer ankommen.

Hybride Realität: von allem etwas

Die meisten Systeme können inzwischen von allem etwas. In-Line-Systeme haben beispielsweise auch Mikrofone im Saal, regenerative Systeme bedienen sich Faltungs- oder anderer Algorithmen, um einen Saal vorzugauklen, den es bei Open-Air-Veranstaltungen gar nicht gibt. 3D-Effekte und die Unterstützung des richtungsrichtigen Hörens lassen sich auch in Raumsimulations-Systeme integrieren. 3D-Systeme wiederum beeinflussen auch die Raumakustik: Die Systeme lassen sich nicht mehr eindeutig in Schubladen packen.

Die Tradition, in der ein System steht, ist eher ein Anhaltspunkt dafür, was es am besten kann. Ziel der folgenden Beispiele ist es, einen Eindruck zu vermitteln, wofür die Systeme eingesetzt werden können.

Beispiele: Raum ohne Raum

Bei klassischen Aufführungen, sei es bei Opern oder Konzerten im Freien, prägt die reale Distanz zwischen Bühne und Zuhörer das Hörerlebnis, wenn nur Direktschall und Frontlautsprecher zu hören sind. Bei den großen Distanzen, wie sie bei der Seebühne in Bregenz oder der Oper im Steinbruch in St. Margarethen zwischen Publikum und Sängern existieren, würde ohne elektroakustische Unterstützung durch Lautsprecher um die Zuschauer herum das Gefühl der Teilhabe und Nähe zum Geschehen auf der Bühne fehlen.

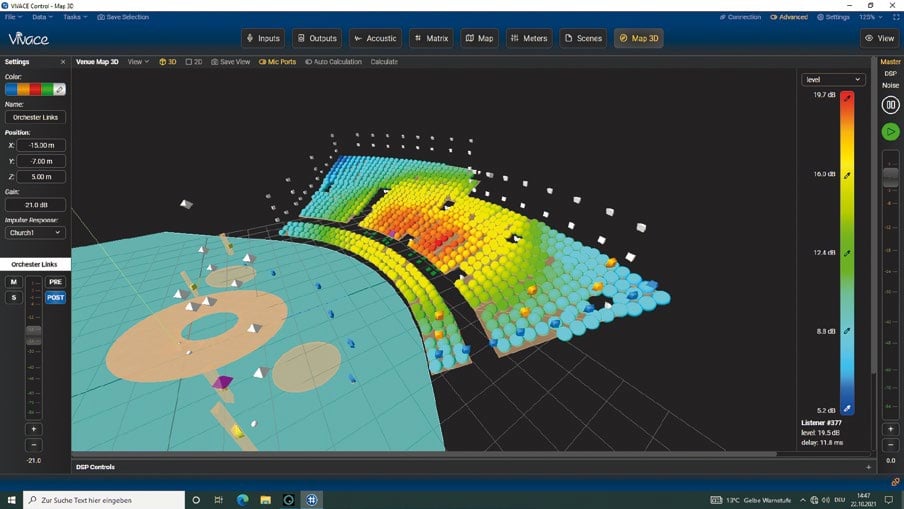

Die Intensität der oft hochkarätigen Stimmen würde leiden. In beiden Fällen wird daher ein räumliches und einhüllendes Klangerlebnis geschaffen. In Bregenz kommt das System Vivace von Müller BBM, in St. Margarethen das Amadeus Active Acoustics von Amadeus Acoustics zum Einsatz.

Bei den St. Gallen Festspielen, eine Opernproduktion im altehrwürdigen Klosterhof, kam das d&b Soundscape zum Einsatz, das mit dem Audioprozessor DS100 und den beiden Modulen En-Space und En-Scene sowohl für die Raumsimulation als auch das richtungsrichtige Hören einzusetzen ist.

Richtungsrichtig hören

Dass man die Sänger bei der Oper auch an der Position hört, wo man sie sieht, hört sich selbstverständlich an. Nicht aber in Bregenz, wenn man rein die räumlichen Bedingungen betrachtet: Die Sänger sind so weit entfernt, dass man sie ohne Verstärkung gar nicht hört, und bei der Größe der Bühne verliert man sie auch schnell mal aus den Augen. Denn es gibt weder Saal noch Orchestergraben, und die „die richtungsrichtige Wahrnehmung ist bei den Entfernungen und Größe der Bühne besonders wichtig, um zu wissen, wer singt, um der Handlung folgen zu können“, erklärte Clemens Wannemacher, Leiter der Tonabteilung der Bregenzer Festspiele beim Besuch der Seebühne vor der Produktion von Madame Buttley. Hier wird das Spatial Sound Stage eingesetzt, das auf die 3-D-Sound-Entwicklungen des Frauenhofer IDMT zurückgeht.

Dieselben Wurzeln hat auch das SSW (Spatial Sound Wave), dass schon seit längerer Zeit im Opernhaus in Zürich zum Einsatz kommt. Hier ging es zunächst darum, Quellen frei im Raum platzieren zu können und 3-D-Effekte zu erzielen. „Die neue Generation Regisseure ist mit dem iPad aufgewachsen. Für sie ist es fast selbstverständlich, dass man Ton auch verschieben kann,“ berichtete Oleg Surgutschow, Tonmeister und Leiter der Abteilung für Bild und Ton, schon 2016. Die einfache Bedienung und Reproduktion von Einstellungen ist für den Produktionsalltag eine Grundanforderung. „In einem Repertoiretheater wie diesem mit täglich wechselnden Produktionen, zwei Produktionen am Wochenende, zwei unterschiedlichen sogar am Sonntag sind die Einrichtungszeiten sehr knapp. Man muss sehr effizient und schnell arbeiten können,“ sagte Oleg Surgutschow. Seit 2016 ist das System um die Raumakustik-Funktionen ergänzt. Grund hierfür war die für Opern eher kurze Nachhallzeit des Saals von 1,2 Sekunden im Mittel, die eher einem Sprachtheater entspricht, und der Wunsch, dem Nachhall mehr Volumen zu verleihen.

Variable Raumakustik

Das passende Volumen per Knopfdruck ermöglichen diverse Raumsimulations-Systeme. Damit dieses möglichst perfekt gelingt und die Zuhörer vom passenden Raum klang eingehüllt und nicht durch Klangverfärbungen und Wahrnehmung von Lautsprechern gestört werden, bedarf die Einstellung Fachkenntnis und Akribie. Dies ist sicher ein Grund, warum beim Meyer Sound Constellation alles aus einer Hand kommt, inklusive der Lautsprecher. Hier ist man beim Amadeus freier, die Lautsprecher-Marke ist nicht festgelegt. Aber auch hier wird das System von Mitarbeitern von Amadeus in Betrieb genommen: In einem mehrtägigen Prozedere werden auch in Zusammenarbeit mit den späteren Nutzern – Toningenieure, Orchester, etc. – die Voreinstellungen erarbeitet, die dann die akustische Wandlung z.B. des Sprechtheaters in ein Opernhaus oder Konzertsaal ermöglicht. Amadeus wurde beispielsweise im Sommer 2023 im Theater in St. Gallen in Betrieb genommen, arbeitet bereits in einem Theater in Lausanne. Es wird auch in multifunktionalen Veranstaltungssälen wie dem Congress Centern Alpbach (CCA in Alpbach, Österreich) und dem Konzertsaal in Andermatt eingesetzt. Letzterer Saal – eigentlich zu klein für große Orchester – sollte für die Berliner Philharmoniker zur Eröffnung akustisch passend sein. Deshalb wurde der Saal mittels Nachhallzeit- und Reflexionsanpassung per Amadeus akustisch „größer“ gemacht.

Einen für Konzerte nicht ganz passenden Saal raumakustisch temporär auch für hochkarätige sinfonische Konzerte geeignet zu machen, dazu kam sowohl im Musical Theater in Basel als auch in der MAAG-Halle in Zürich das Viviace-System von Müller BBM zum Einsatz. In beiden Fällen wurden die eigentliche, historischen Spielstätte für klassische Konzerte restauriert und während der mehrjährigen Bauarbeiten ein Ersatzspielort geschaffen.

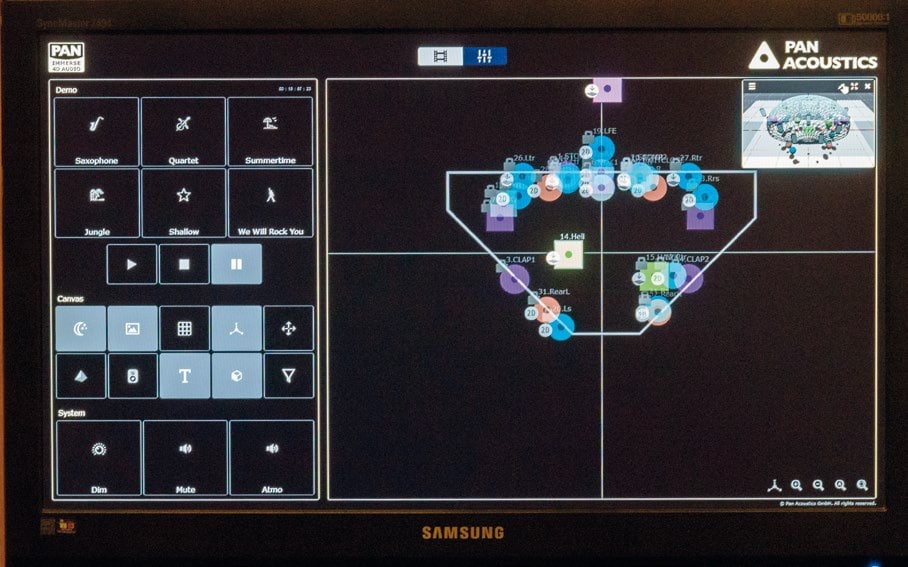

Auf der Bühne

Für Orchestermusiker ist es fundamental, sich gegenseitig zu hören. Dies kann aber ohne die entsprechenden baulichen Einrichtungen wie eine Orchestermuschel schwierig sein. Bereits 2005 verfügte das ACS (Acoustic Control System, inzwischen bei Pan Acoustics angesiedelt), über Funktionen, mit denen die für das gegenseitige Hören wichtigen frühen Reflexionen erzeugt und über Lautsprecher wiedergegeben werden. Darüber hinaus kann ACS, das mit der Aufnahme des Direktschalls in der Tradition der In-Line-Systeme steht, natürlich noch einiges mehr: Nachhallzeiten im Saal verlängern, erste Reflexionen für die Zuhörer erzeugen usw.

Sprache unterstützen

Für Vortragende kann es angenehm sein, einfach frei zu reden und nicht in ein Mikrofon sprechen zu müssen. Nur leider fehlt es dann oft an Lautstärke, um auch auf etwas weiter entfernten Plätzen gut verstanden zu werden. Hier kann die „Voice-Lift“-Funktion beispielsweise im Yamaha AFC3 die Sprache durch Erzeugung früher Reflexionen unterstützen. Die Signale, die dann über Lautsprecher wiedergegeben werden, sind leicht verzögert. Die Unterstützung basiert auf den „integrativen“ Eigenschaften des Ohres: Bei den frühen Reflexionen bis ca. 50ms nach dem Direktschall integriert das Ohr, es unterscheidet bei der Empfindung der Lautstärke nicht zwischen den Signalen, sondern „hört“ den Pegel als Summe aus Direktschall und ersten Reflexionen. Durch das Erzeugen eines Summensignals (Direktschall und mit dem AFC3 erzeugte erste Reflexionen) wird der Sprecher lauter empfunden als nur der Direktschall in einem trockenen Raum. So lange das Sprechersignal zuerst beim Hörer ankommt und immer noch eine gewisse Lautstärke hat, stimmt die Wahrnehmung der Sprecherposition. Voice Lift kennt zwei Modi – den Präsentation-Modus, bei dem der Vortagende unterstützt wird, und den Konferenz-Modus, bei dem Sprecher auch an unterschiedlichen Positionen im Raum verstärkt werden, ohne dass sie selber ein Mikrofon brauchen.

Als hybrides System beherrscht AFC3 auch die Disziplinen der Raumsimulationen, und eine Sprachunterstützung ist im Gegenzug auch in anderen Systemen integriert.

Mehr als 3D-Effekte

Die Beispiele verdeutlichen, wie breit gefächert die Anwendungen der Systeme im Veranstaltung- und Konzertalltag sind. Sie könne die Raumakustik beeinflussen und den Zuhörer akustisch in eine dreidimensionale Welt entführen, die sowohl einer gewohnten und gewünschten Hörumgebung entsprechen – als auch eine surreale Hörerfahrung erschaffen kann.

L-ISA für die Mainstage der LEaT con

Audiovorführungen bedeuten manchmal, Eulen nach Athen zu tragen … „jaja, kennen wir schon“. Für die LEaT con hat sich das Team daher zusammen mit L-Acoustics ein Setup ausgedacht, das gleichzeitig noch nicht weit verbreitet, aber besonders praxisnah ausfällt. Die Entscheidung auf ein mehrkanaliges Setup in der Front ist damit sicher deutlich repräsentativer für viele Aufträge als ein ausgewachsenes Rundum-Paket.

Die Fragestellungen, die sich hier in der Vorbereitung ergaben, waren damit ganz typisch für viele Jobs: Welches Programm findet auf der Bühne statt? Welche akustischen Vorteile sind tatsächlich im gegebenen Programmablauf erwartbar? Lässt sich die Bestuhlung etwas anpassen? In welchem Format werden die Einspieler geliefert, und welche Schnittstellen ins System werden benötigt? Welche Hängepunkte sind realistisch? Wie passt der Gesamtaufwand ins Budget? Nicht zuletzt: Welche Flächen umgeben Bühne und Publikum und dürfen nicht gestört werden?

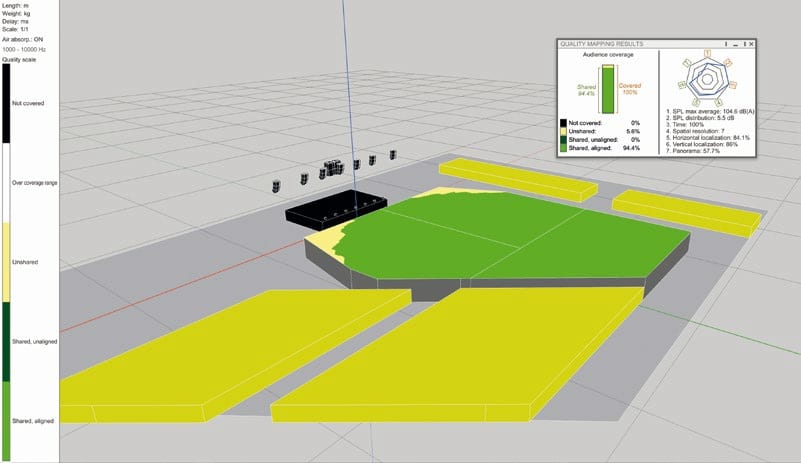

Martin Rode, Senior Application Project Engineer für den deutschsprachigen Raum bei L-Acoustics, definierte daraus folgende Aufgabenstellung: „Mit L-ISA verfolgen wir bei der gegeben Aufgabenstellung den Ansatz, eine frontale Beschallung zu realisieren, bei der die akustische richtungsbezogene Lokalisation der Zuhörer im Einklang mit der visuellen Wahrnehmung der Akteure (Sprecher oder Musiker) auf der Bühne steht. Sprich: Wir heben die klassische Fehllokalisation auf, die sich bei einem L/R-System für Zuhörer ergibt, die außerhalb der Mitte sitzen. Dieser Ansatz steht im Einklang mit dem natürlichen Hören akustischer Schallereignisse, weshalb die Rezipienten die Beschallung nicht mehr als künstliche Barriere wahrnehmen. Ziel ist es, dies für die überwiegende Mehrheit des Publikums zu erreichen, um eine größere Gleichbehandlung der Zuhörer zu erreichen. In der vorliegenden Planung erreichen wir dies für 94,4% der Hörerfläche.“

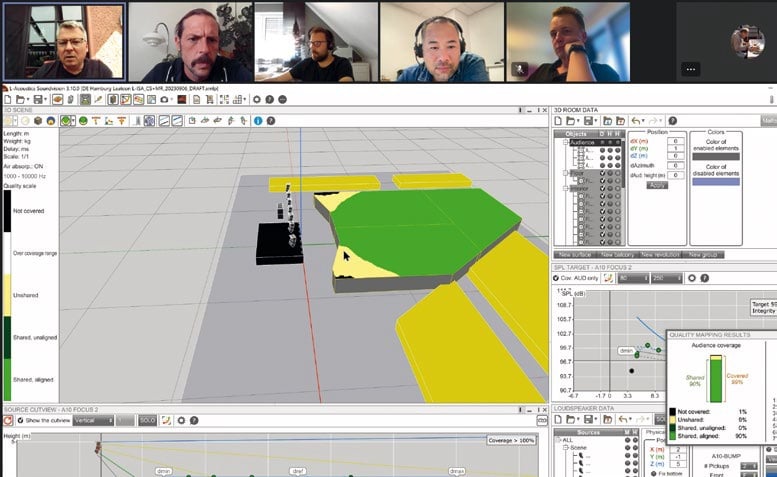

Planungsschritte und Aufwand

Auch für die LEaT con wurde die finale Planung nicht in einem Schritt gefunden, sondern erfolgte in einigen Abstimmungen zwischen Veranstalter, Planer und Dienstleister: „Generell durchläuft eine solche Planung einen Abstimmungsprozess mit den Kollegen vom Licht (Stichwort: Platzkampf an der Fronttraverse), den Videokollegen (Stichwort: Aufpro), dem Setdesign und der technischen Leitung. Hier ergeben sich in der Regel leichte Veränderungen, und man schließt Kompromisse. Fundamentale Änderungen ergeben sich in der Regel nicht, wenn das L-ISA System von der Produktion und/oder dem Künstler gewollt ist.“

Ein gewisser Mehraufwand gegenüber einer „Standardbeschallung“ ist natürlich gegeben. Wie hoch schätzt Martin Rode ihn im Schnitt ein? „Der Mehraufwand ist gegeben, da anstatt zwei L/R-Systeme und ggf. einem Center immer mindestens fünf Arrays geflogen werden. Die Tournee-Erfahrung bei Mark Knopfler oder Bon Iver zeigen aber, dass dies mit der entsprechenden Vorbereitung nicht dramatisch ist und dass der Nutzen diesen Mehraufwand bei Weitem überwiegt. Zudem wird es in der Zukunft noch einfacher: Mit der neuen Trussklemme CLAMP1000, die Arrays bis 1.000kg nach BGV-C1 fliegen und unter Last eindrehen kann, haben wir zudem einen großen Schritt gemacht, um schnellstmöglich anzuschlagen und auszurichten. Mit dem vorgecurvten L2 und L2D ist zudem ein neues System am Markt, dass die Rüstzeiten gegenüber herkömmlichen Arrays mit variablen Winkeln um ca. 68% herabsetzt, weshalb in dieser Konstellation der zeitliche Mehraufwand voll kompensiert ist.“

Das Team von L-Acoustics ist hier also deutlich positioniert und überzeugt, aber sieht es dennoch gelegentlich Nachteile – wie eine manchmal kritisierte empfundene „akustisch Indirektheit“ solcher Setups? Martin Rode: „Nein, insgesamt sehe ich hier in der Summe nur Vorteile für den Mix, die Abbildung und die Rezeption. Wir merken das immer daran, dass wir beispielsweise Maskierungseffekte nicht mehr mit invasivem EQ-Einsatz begegnen müssen, sondern dies über die räumliche Anordnung der Instrumente lösen. Hierdurch können die Einzelinstrumente viele natürlicher klingen. Darüber hinaus erfahren wir bei Konzerten immer wieder, dass Zuhörer am FOH erscheinen und fragen, was mit dieser Beschallung anders sei als sonst. So habe man das in der Halle noch nie gehört. Hier findet aus unserer Sicht eine massive Aufwertung der musikalischen Übertragungsqualität statt, die die Zuhörer mitnimmt.

Einziger Nachteil ist in manchen Bühnensituationen, dass wir gehalten sind, die Systeme recht hoch zu fliegen, um die Sichtlinien einzuhalten. Hierdurch ist dann die vertikalen Ortung im Nahbereich der Bühne zu hoch, was wir aber über sogenannte Spatialfill-System an der Bühnenkante für die ersten Reihen kompensieren können.“

Dieses Konzept ausgiebig – sicher ganz losgelöst von konkreten Marken – im realen Konferenzalltag zu erleben, war auf der LEaT con vom 17. bis 19. Oktober in Hamburg möglich.