Die rasante Entwicklung von künstlicher Intelligenz und smarten Anwendungen hat unsere technologische Landschaft schon jetzt revolutioniert. Der Artikel wirft einen Blick auf KI in der Medien- und Veranstaltungstechnik – und arbeitet am Beispiel von Crestron-Produkten Gemeinsamkeiten und Unterschiede zu smarten Anwendungen heraus. Das vorgestellte Mehrkamerasystem von Crestron etwa verdeutlicht, wie leistungsstark und vielseitig solche Systeme schon jetzt sein können, wenn man smarte Anwendungen und die noch in Teenagerschuhen steckende KI auf intelligente Weise vereint. Die Hybridlösung Automate VX wiederum bietet nicht nur beeindruckende Bildqualität, Automatisierung und Effizienz, sondern gleichzeitig Anpassungsfähigkeit und Benutzerfreundlichkeit.

Die EU hat im August 2024 eine KI-Verordnung erlassen, die sicherstellen soll, dass Künstliche Intelligenz verantwortungsbewusst und sicher eingesetzt wird, weil der Fortschritt so rasant ist. OpenAI Sora (Teil von ChatGPT) kann seit Dezember 2024 fotorealistische Videos anhand von Texteingaben, Bild- oder Videomaterial generieren. Nvidia Chef Huang sagt voraus, dass KI sehr schnell viele Jobs im Bereich Computerwissenschaften verdrängen wird, weil KI einige Dinge schon jetzt besser beherrscht als jeder Mensch. Ein bisschen ähnlich wie damals beim mechanischen Webstuhl. Es wird eine Verlagerung der Arbeitsplätze geben.

Prognosen für die erste Künstliche Allgemeine Intelligenz (engl. AGI, Artificial General Intelligence) besagen mittlerweile, dass schon um das Jahr 2029 eine allgemeine KI existieren könnte, die jede intellektuelle Aufgabe ausführen kann, die ein Mensch ausführen kann! Also nicht nur eine Aufgabe (das ist heute schon der Fall), sondern jede. Noch vor wenigen Monaten waren diese Prognosen deutlich zurückhaltender. Sobald es AGI geben wird, sind wir nicht mehr die schlauesten Entitäten auf dem Planeten. Es ist also jetzt an der Zeit, sich mit KI vertraut zu machen, um nicht den Anschluss zu verlieren. Aber muss es wirklich immer KI sein? Wo liegen die Vorteile und Unterschiede zu anderen schlauen Lösungen? Für viele kleine Aufgaben genügen smarte Anwendungen oder sind sogar besser geeignet als KI. Wie setzt Crestron KI ein? Welche Art von KI? Lassen Sie uns loslegen.

Schon Platon und Aristoteles sahen Intelligenz als die Fähigkeit an, die den Menschen vom Tier unterscheidet. Beim Menschen meint Intelligenz das Denken und Reflektieren. Bei der Definition künstlicher Intelligenz oder kurz KI (im Engl.: AI, Artificial Intelligence) werden oft zusätzlich das Erkennen von Muster oder das Verstehen menschlicher Sprache genannt. Dies wird bei Menschen offensichtlich vorausgesetzt. Durch stetig schneller werdende Computer wird es heutzutage immer erschwinglicher, Künstliche KI gewinnbringend zu bemühen. Aber kommen wir im ersten Schritt zu den Hintergründen.

Die Technologien hinter KI

Künstliche Intelligenz basiert auf einer Reihe fortschrittlicher Technologien. Eine davon ist das Machine Learning. Dafür sind zwei Dinge essenziell: Daten und Rechenleistung. Man übergibt der Maschine eine große Menge an Daten, aus denen sie lernen und Ergebnisse ableiten soll. Daten haben wir mittlerweile genug, wir Menschen produzieren eher zu viele Daten, die niemand mehr überblicken kann. Und fast alle Daten sind heutzutage im Internet zugänglich. Für das Durchforsten und Verwenden dieser riesigen Datenmengen ist, zweitens, eine enorme Rechenleistung nötig. Auch diese können wir mittlerweile bereitstellen. Grafikkartenchips sind dabei heutzutage schneller als eigentliche CPUs, weil sie schon immer darauf ausgelegt waren, mit großen Datenmengen wie den Millionen Pixeln und Vektoren in Computerspielen umzugehen. Daher auch die positive Positionierung vom Marktführer Nvidia im Aktienmarkt.

Wenn man zum Beispiel einer Kamera die Gesichtserkennung beibringen möchte, dann muss man der KI sehr, sehr viele Fotos von Gesichtern geben. Es gibt verschiedene Techniken für den Lernprozess: Oft werden auch Fotos ohne Gesichter beigemischt; diese Daten werden dann etwa als „kein Gesicht“ gekennzeichnet, damit die KI lernen kann, tatsächliche Gesichter von nur ähnlichen Formen oder Gemälden oder Fotos zu unterscheiden. Wie genau die KI eigentlich zum Ergebnis kommt, wissen wir oft nicht mehr. Weil sie abstrakt und schneller arbeitet und mehr Dinge gleichzeitig tun kann.

Die nächste Technologie, Deep Learning, wiederum ist Machine Learning, basierend auf neuronalen Netzen. Neuronale Netze wurden schon 1943 in der Theorie von den Amerikanern Warren McCulloch und Walter Pitts entwickelt. Sie empfinden im Prinzip das Gehirn nach: eine Gehirnsynapse wird durch einen virtuellen Knoten dargestellt, der von anderen Knoten Informationen erhält (Eingabeschicht), diese Informationen auswertet (verborgene Schicht) und an andere Synapsen ein binäres Ergebnis (0 oder 1, Ja oder Nein) weitergibt (Ausgabeschicht). Dadurch können viele kleine Aufgaben sehr schnell parallel von vielen Knoten bearbeitet werden und nicht nur zentral von einem Computerchip.

Grundlage dafür war die Annahme vom britischen Logiker Alan Turing, dass jedes größere Problem in kleinere Teilprobleme aufgeteilt werden könnte. Die neuronalen Netze sind sehr viel schneller, aber auch sehr viel aufwendiger als herkömmliche Programme. Daher erleben wir erst heute das Aufkommen von immer mehr KI-Anwendungen; weil die Rechenleistung es erst jetzt zulässt.

Weitere KI-Technologien sind z. B. Knowledge Representation und Natural Language Processing (NLP). Ersteres meint, dass der PC die Informationen aus der Umwelt in einer PC-gerechten Form speichern muss, damit er sie verstehen und nutzen kann. NLP bezieht sich auf das Verstehen, Interpretieren und Erzeugen menschlicher Sprache, wie es heute in Chatbots und Sprachassistenten passiert.

Und schließlich gibt es Computer Vision. Darunter versteht man, dass KI in der Lage ist, anhand von Bildern oder Videos die reale Umwelt zu erkennen, zu verarbeiten und zu interpretieren. Mit dem Einsatz von Computer Vision beschäftigen wir uns später näher.

Was KI heute schon alles für uns tut

Der Begriff Künstliche Intelligenz etablierte sich 1956 während der Dartmouth-Konferenz in den USA. Seit damals gibt es KI auch als Wissenschaftszweig. Vom Normalbürger wahrnehmbar wurde KI aber erst in den Jahren ab 2010, als Apple Siri und Amazon Alexa auf den Markt brachten und Netflix und Spotify Nutzerempfehlungen auf KI stützten. Man konnte zum ersten Mal mit dem Handy sprechen, und es hat Aufgaben für uns ausgeführt.

Und 2022 kam dann ChatGPT von Open AI. Plötzlich konnte eine Maschine alle verfügbaren Informationen aus verschiedensten Quellen nutzen, um Fragen zu beantworten oder Aufgaben auszuführen. Man fragt nicht mehr Google nach einer gesuchten Information und muss diese dann selbst in den vielen online verfügbaren Inhalten sichten. Sondern die Maschine erledigt das für uns.

Copilot ist mittlerweile in Microsoft Office/Teams integriert und kann dort immer mehr Arbeitsschritte für uns erledigen, die sich bei Meetings wiederholen. Es transkribiert Konferenzen, protokolliert, erstellt Zusammenfassungen, leitet Aufgaben von den besprochenen Themen ab und weist sie Personen zu. KI übersetzt Gespräche in Echtzeit, kann die menschliche Stimmung anhand von Stimme, Tonfall und Wortschatz erkennen und vieles mehr. KI nimmt uns schon jetzt sehr viel Arbeit ab und ist aus vielen Bereichen (Medizin) nicht mehr wegzudenken.

Smarte Anwendungen vs. KI

Was aber unterscheidet KI nun von smarten Anwendungen? Tatsächlich sind die Differenzen oft kaum zu bemerken. Das erste smarte Industriegebäude gab es 1963. Wenn darin ein Brandmelder ausgelöst hat, meldete ein Klingeldraht automatisch: Hier brennt es. Oder wenn eingebrochen wurde, setzte das System eine Störmeldung ab. Das war im Ergebnis ein smartes Industriegebäude, schon schlau, aber noch weit entfernt von Künstlicher Intelligenz.

Bei smarten Anwendungen oder Programmen handelt es sich immer um Wenn-Dann-Verknüpfungen: Wenn Fenster auf, dann Störmeldung. Programme führen nur vordefinierte Befehle aus, während KI gegebenenfalls kontinuierlich aus vorherigen Ein- und oder Ausgaben lernt oder vorab trainiert wurde, um Entscheidungen zu treffen (Gesicht oder kein Gesicht).

Das erste Smart Home gab es 1966. Der US-Ingenieur James Sutherland schuf für seine Idee eines vernetzten, vollständig automatisierten Hauses den „Electronic Computing Home Operator“, kurz ECHO IV. Das Smart Home konnte verschiedenste Dinge unter einen Hut bringen, z. B. das Haushaltsinventar und Kalendereinträge verwalten.

Kinder mussten erst Fragen beantworten, bevor sie den Fernseher nutzen durften, und Texte, die auf einer IBM-Schreibmaschine getippt wurden, konnten gespeichert und abgerufen werden. Uhren und Heizung ließen sich steuern. Dafür waren entsprechende Sensoren (Fenster auf oder zu, Temperaturmesser, Rauchmelder usw.) nötig, die die Informationen der Umgebung lesen und weitergeben können. Erst als die Sensoren so weit waren, konnte man damit smarte Dinge tun. Und genauso funktionieren smarte Anwendungen noch heute.

Smarte Anwendungen und Steuerungen bei Creston

Auch Crestron hat viele smarte Anwendungen zu bieten. Mit unserem Präsenzmelder kann man Räume automatisiert ausschalten, wenn sie nicht genutzt werden. Wenn zu einem geplanten Meeting nach zehn Minuten noch niemand im Raum ist, möchte man vielleicht die Bildschirme und das Licht ausschalten, um Strom zu sparen.

Bei Crestron nutzen wir übrigens lieber Präsenzmelder, keine Bewegungsmelder. Der Unterschied zeigt sich auf dem Klo. Sie kennen das vielleicht: Wenn man sich nicht bewegt, dann geht bei einem Bewegungsmelder das Licht aus. Unsere Infrarotsensoren im Präsenzmelder erfassen dagegen auch die Wärme von Menschen. Wenn Sie warm genug sind, dann bleibt das Licht an.

Anderes Beispiel: Wenn es draußen zu hell ist, dann können wir dafür sorgen, dass Rollos automatisch runterfahren. Eine weitere Anwendung, die sehr intelligent erscheint, obwohl sie nur smart ist, findet man auch beim automatischen Umschalten vieler Crestron-Produkte: Sobald eine Person ihren Laptop an einen HDMI-Anschuss im Raum steckt, schaltet sich automatisch das Display an, und der Bildschirm schaltet auf den korrekten HDMI-Eingang.

Steuerungen und Interfaces, EIB und KNX

Das erste Gebäude mit einem Zentralrechner gab es 1973. Die Idee dabei war ähnlich wie beim Smart Home, verschiedenste Dinge von einem Zentralrechner aus zu steuern. Auch bei Crestron nutzen wir meist eine zentrale Steuerung als Herzstück oder „Gehirn“ einer Installation. Es gibt Modelle für den Rack-Einbau (Produktname CP4), freistehend (RMC4) oder zum Einbau in die Hutschiene (AP4).

Jede Steuerung ist dabei im Grunde nichts anderes als ein kleiner PC, auf dem eine Steuerungssoftware läuft. Mittlerweile kann man unsere Steuerungssoftware auch als Lizenz kaufen und auf einem eigenen PC oder Server installieren. Zentrale Steuerungen funktionieren quasi immer noch so wie in 1973. Nur schneller.

1991 wurde dann der Europäische Installationsbus EIB ins Leben gerufen. Der war zum ersten Mal in der Lage, mit einer Steuereinheit verschiedenste Systeme zu vernetzen: Heizung, Kühlung, Lüftung, Verschattung u. Ä. Damit es eben nicht so ist, wie man es von zuhause kennt: Man hat drei oder vier Fernbedienungen für alle möglichen Geräte, die ständig in Sofaritzen verschwinden.

Auch das machen wir bei den Crestron-Steuerungen heute noch genauso: Sogenannte Interfaces oder auch Gateways erzeugen aus unseren Crestron-Befehlen Anweisungen, die für das jeweilige System verständlich sind, also für Thermostate, Dimmer-Module, Motorsteuerungen und so weiter. Die Crestron-Steuerung gibt einen Befehl, z. B. Licht an. Dieser Befehl muss dann von einem Interface übersetzt werden in die Sprache der Lichttechnik (z. B. DALI oder DMX).

Auch unsere Crestron XiO Cloud ist eine sehr smarte Anwendung. Die XiO Cloud ist ein Überwachungs- und Management-Tool von Crestron, mit dem man nicht nur Crestron-Geräte, sondern alle medientechnischen Geräte managen kann, die sich per LAN oder API-Schnittstelle ansprechen lassen. Somit kann man alle Geräte im Gebäude aus der Ferne auslesen, überwachen und steuern. Ich kann mir damit z. B. auch live anschauen, was mein Kollege in einer Filiale in Hongkong gerade auf seinem Touch-Panel sieht (nur wenn der Kollege die ferngesteuerte Bedienung auf dem Touchpanel freigibt).

Und vor allem kann das System pro-aktiv Hinweise per E-Mail oder SMS versenden, wenn es irgendwo zu Fehlern kommt. So weiß der Techniker schon vorher, ob man das Problem eventuell aus der Ferne lösen kann oder welche Ersatzteile im Service-Fahrzeug sein müssen.

Wo setzt Crestron KI in seinen Produkten ein?

Crestron nutzt Künstliche Intelligenz am häufigsten in Form von Computer Vision bei den Kameras und Kamerasystemen, also zur Identifizierung und Klassifizierung von Gesichtern und Objekten in Bildern und Videos. Die Kameras sind in der Lage, Gesichter zu identifizieren, damit diese z. B. vergrößert dargestellt werden können. Das ist enorm wichtig für die Gleichberechtigung bei hybriden Meetings. Was meine ich mit Gleichberechtigung?

Bei hybriden Meetings sitzen eine oder mehrere Personen tatsächlich im Konferenzraum und andere Personen wählen sich aus der Ferne ein, um teilzunehmen. Mein Kollege Alex und ich haben zum Beispiel an einem Sales Meeting in Frankfurt nur per Teams aus der Ferne teilgenommen, während unsere Kollegen alle vor Ort in einem Konferenzraum mit nur einer Kamera waren. Wir haben also zwei Tage lang den ganzen Tag über 20 nur sehr klein zu sehende Köpfe oder Rücken von unseren Kolleg:innen gesehen. Wir konnten die Atmosphäre im Raum schlecht lesen, die Emotionen der Redner nicht erkennen, wussten nicht, wo wer gerade spricht, und am Ende fühlten wir uns ausgeschlossen und nicht involviert und haben eher anderes gemacht als aktiv an dem Meeting teilzunehmen.

Crestron trainiert die KI dabei nicht selbst, sondern nutzt fertige Gesichtserkennungsmodelle. Unser System wird auch nicht weiter angelernt und verbessert sich auch nicht weiter. Die KI hat also die Gesichtserkennung durch Deep Learning erlernt, die Implementierung dagegen findet ohne weiteres Lernen statt. Dafür sind dann auch keine Hochleistungscomputer nötig wie beim Trainieren einer Künstlichen Intelligenz.

Gesichtserkennung mit der Videobar 70

Ein perfektes Beispiel für den Einsatz von Gesichtserkennungsmodellen ist die All-In-One Videobar 70. Das ist eine Videobar mit integriertem, Android-basiertem Computer. Auf dem Rechner läuft Teams (MTR = Microsoft Teams Room) oder Zoom Room. Dazu gibt es ein Touchpanel von Crestron, mit dem man die Konferenz steuert. Die Videobar beinhaltet vier hochwertige 4K-Kameras, Stereo-10-Watt-Lautsprecher und ein Array aus 24 Mikrofonen.

Warum gleich vier Kameras? Wenn man nur eine hätte, dann würde ein:e Online-Teilnehmer:in wie im Beispiel eben die Konferenzteilnehmer vor Ort nur sehr klein dargestellt sehen. Man fühlt sich nicht zugehörig, sondern ausgeschlossen. Was also braucht man, um sich gleichberechtigt zu fühlen? Man möchte die Gesichter und Emotionen der Teilnehmer erkennen, mindestens, wenn sie gerade sprechen.

Ein Problem für die Zukunft wird sein, auch die nicht-sprechenden Teilnehmer im Raum zu erfassen. Denn auch ohne einen Ton kann man sehr viel durch Mimik und Gestik ausdrücken. Hochgezogene Augenbrauen sagen manchmal mehr als das gesprochene Wort. Was benötige ich, um Gesichter entsprechend groß darstellen zu können? Möglichst mehrere Kameras, die ein Gesicht auch heranzoomen können!

Und genau das tut die All-In-One-Videobar. Automatisch zeigt sie etwa im Konversationsmodus die Gesichter der beiden jeweils letzten Redner nebeneinander. Unterhalb der Gesichter wird eine komplette Raumansicht gezeigt (ansonsten verliert man schnell aus den Augen, wer wo im Raum sitzt und mit wem gesprochen wird).

Intelligente Kameras

In den intelligenten Kameras von Crestron findet man sogar beide Welten: smarte Anwendung und Künstliche Intelligenz. So ist etwa unser Doppel-Kameras-Setup (bestehend aus i12- und/oder i20-Kameras) eigentlich nichts anderes als nur smart: Es gibt zwei Kameras im Raum – eine vorn und eine hinten. Die vordere Kamera erfasst durch ein Group Framing alle im Raum befindlichen Personen und öffnet den Kamerawinkel so weit, dass immer alle gut zu sehen sind.

Aber was, wenn jemand nach vorn tritt, um etwas am Whiteboard oder Display zu präsentieren? Dann erfasst die vordere Kamera ihn oder sie nicht mehr. Dazu gibt es die zweite Kamera von hinten: diese Kamera übernimmt automatisch, sobald jemand in einen vorher eingerichteten Präsentationsbereich hineintritt und verfolgt diese Person (oder sogar mehrere Personen!) auf Wunsch.

Diesen Bereich legt man mit der Maus per Drag & Drop im Kamera-Manager innerhalb von Sekunden fest. Verlässt die Redner:in den Bereich wieder, übernimmt automatisch wieder die vordere Group-Framing-Kamera. Die Verschaltung der Kameras wirkt in der Realität sehr intelligent, weil die Umschaltungen komplett automatisch passieren, ist aber nichts anderes als eine Logik (smarte Anwendung).

Für das beschriebene Group Framing, Presenter Tracking und Group Tracking nutzen die Kameras hingegen tatsächlich die KI-Gesichtserkennungsmodule. Die intelligenten Kameras i12 und i20 haben dafür eine zusätzliche Weitwinkel-Kameralinse gut erkennbar vorn unter der PTZ-Linse. Diese zusätzliche Kamera dient der Erfassung des Raumes und der Gesichter. Bei den normalen PTZ-Kameras p12 und p20 fehlen diese zusätzliche Linse und Gesichtserkennung und Framing/Tracking. Alle Kameras haben eine Reichweite von 9 Metern.

Vielleicht reichen aber zwei oder vier Kameras auch nicht aus? Vielleicht ist mein Raum zu wichtig oder zu groß, und ich brauche noch mehr Kameras und Logik bzw. Intelligenz. Was dann? Meist musste dann bisher die Verschaltung vieler Kameras sehr zeitaufwendig programmiert werden, weil für jede Eventualität im Raum eine Aktion festgelegt werden muss. Crestron Automate VX löst diese Hürde sehr viel graziler, lassen Sie mich erklären, wie.

Automate VX und der Room Designer

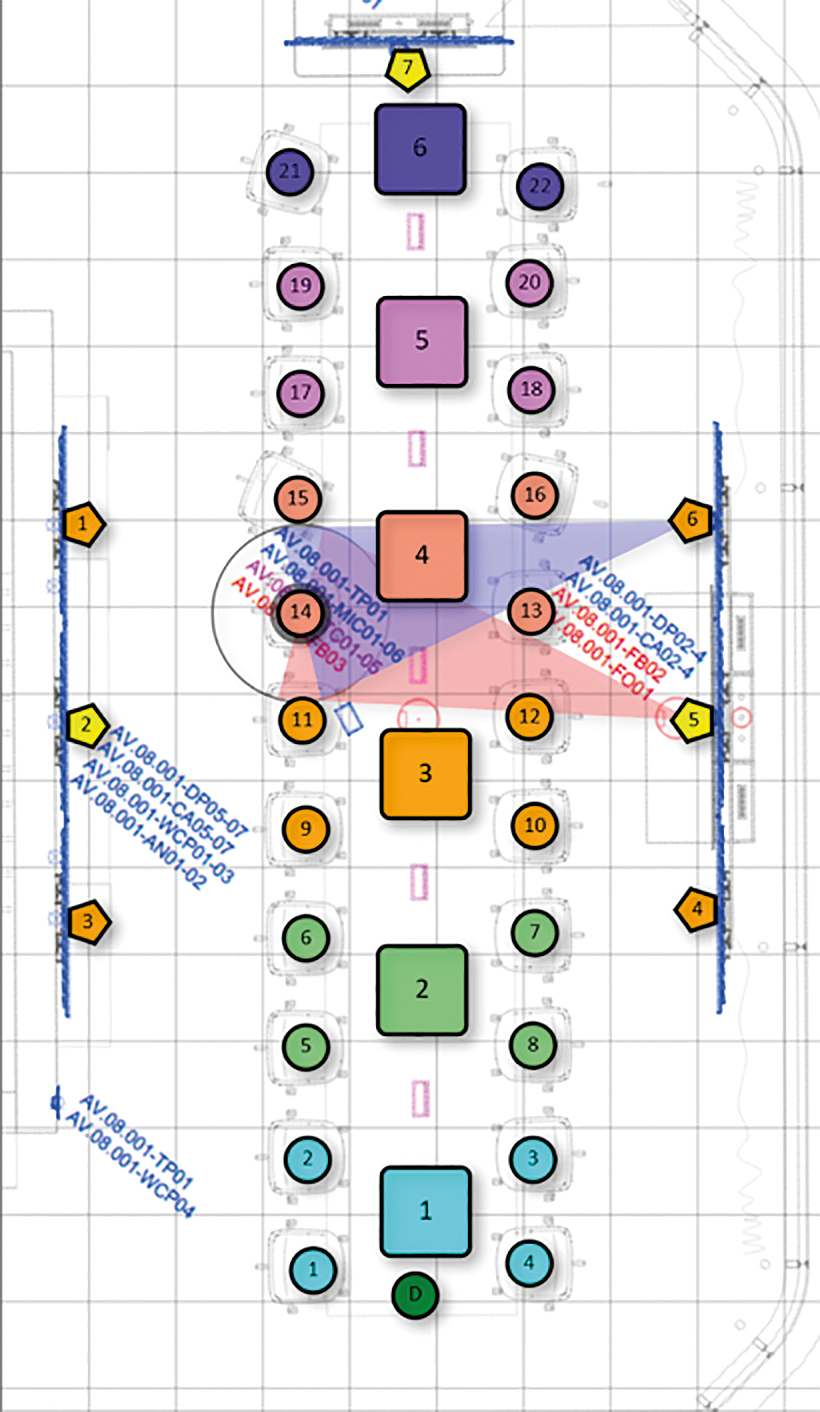

Crestron Automate VX heißt die bahnbrechende Lösung aus dem Hause Crestron. Wir setzen dabei nicht auf Programmierung, sondern auf visuelle Konfiguration. Unser System benötigt für die Konfiguration nur einen Grundriss, auf dem man im kostenlosen Online-Room-Designer von Crestron alle Sitzpositionen und Kamerapositionen per Mausklick einträgt. Wir benötigen Mikrofone im Raum, um herauszufinden, wo im Raum gerade gesprochen wird. Es ist nämlich ein sogenanntes audiobasiertes System. Wir sind dabei Hersteller-neutral und lassen alle namhaften Hersteller von Mikrofonen und Signalprozessoren zu (egal ob Sennheiser, Shure, Audio Technica, Biamp, QSC, Televic, Bosch, TAIDEN …). Man kann Deckenmikrofone oder auch Sprechstellen oder gar drahtlose Mikrofone nutzen.

Die bis zu 40 Kameras werden alle mit unserem Automate VX Server verbunden, die KI befindet sich sowohl in den einzelnen Kameras (wenn Sie denn Crestron Kameras nutzen) als auch auf dem Automate VX Server. Das System kann dann anhand der Mikrofone auslesen, wo im Raum gerade gesprochen wird. Pro Sitzposition werden immer zwei Kameras zugewiesen. Eine primäre und eine sekundäre Kamera.

Warum? Wenn eine Person anfängt zu sprechen, übernimmt automatisch die Hauptkamera. Wenn genau neben der Sprecher:in jemand anders redet, kann ja die gleiche Kamera nicht zwei Gesichter groß darstellen, würde also entweder weiter weg zoomen, um beide Gesichter darzustellen oder immer hin- und herschwenken. Und Schwenks in einer Videokonferenz sind im wahrsten Sinne schwindelerregend. Ich brauche also eine zweite Kamera für jede Person, die oft direkt neben der ersten Kamera oder wenigstens an der gleichen Wandseite positioniert ist, um Gesichter von vorn darstellen zu können.

Unser visueller Ansatz mit Grundriss hat den großen Vorteil, dass Sie sich schnell in die Planung hineindenken können und außerdem auch recht leicht mehrere Szenarien für unterschiedliche Bestuhlungen erstellen können. Versuchen Sie das mal mit einer Programmierung!

Außerdem werden alle Projektinformationen in dieser einen Room-Designer-Datei gespeichert und auf den Server geladen. Sie können also auch in mehreren Jahren noch ganz einfach auf diese Planung/Konfiguration zugreifen und müssen nicht erst eine ursprüngliche Programmierung heraussuchen. In der Praxis sind alte Programmierungen oft nur schwer auffindbar.

Bei Automate VX sorgt KI im Server jetzt schon dafür, dass Personen immer mittig im Bild behalten werden. Das heißt, die Kamera schaut sich immer an, wo das Gesicht ist. Wenn das Gesicht an den Bildrand wandert, zieht die Kamera durch Schwenken oder Zoomen ein wenig nach. Dies passiert ohne Hinzutun automatisch, wieder basierend auf Gesichtserkennung. Dadurch kann man in der Grundeinstellung schön nah an die Gesichter heranzoomen, ohne zu riskieren, dass Sprecher:innen dann im Betrieb nur abgeschnitten zu sehen sind.

Der nächste große und schon geplante Fortschritt für unser System wird die automatische Auswahl derjenigen Kamera im Raum sein, die das Sprecher:innen-Gesicht am besten möglichst frontal von vorn darstellen kann. Zurzeit legen wir ja immer noch primäre und sekundäre Kameras pro Sitzplatz fest. Was aber passiert, wenn zwei Leute miteinander diskutieren und nicht mehr in Richtung Kamera sehen? Die Kameras können in dem Fall beide Gesichter vielleicht nur von der Seite erfassen. In diesen Fällen wird unser System künftig bald selbständig entscheiden können, welche Kamera ein Gesicht am besten von vorn erfasst hat, und automatisch diese Kamera nutzen.

Automate VX kann gleichzeitig bis zu 12 (nativ) bzw. 40 (mit vorgeschaltetem Videomischer) Kameras nutzen, inkl. NDI. Das müssen keine Kameras von Crestron sein. Unser System ist außerdem stark individualisierbar durch die voll-integrierte Bildmischer-Streaming-Software Wirecast: Erstellen Sie im Handumdrehen verschiedene Layouts, Bild-in-Bild, halbtransparente Bilder, Einblendungen, Bauchbinden, Logos, Videos. Sie bestimmen, was Ihr Gegenüber sieht! Per Touchpanel umschaltbar. Überdies kann jeder einzelne Kamera-Stream aufgezeichnet werden, was etwa in Gerichten sehr wichtig ist.

Zum Abschluss ein Angebot: Sie können sich das System und die Funktionen jederzeit in einem 30-minütigen Online-Termin von uns zeigen lassen, melden Sie sich gern unter Maurice.Camplair@crestron.com