Autonom, unermüdlich und mit außergewöhnlicher Wahrnehmung: Der Einzug von kognitiver Robotik in ProAV-Umgebungen setzt Maßstäbe an Effizienz und eröffnet neue Dimensionen für Servicekonzepte der Zukunft. Die Integration analytischer, generativer und physischer KI ermöglicht Robotern, selbständig komplexe audiovisuelle Aufgaben zu bewältigen. Damit nicht genug: Die nächste Stufe der Transformation nimmt bereits greifbare Formen an: Humanoide Roboter halten Einzug – als intuitive Assistenten, die mitdenken, mitfühlen und sich in kreative Arbeitsprozesse integrieren.

Fliegende Kameras

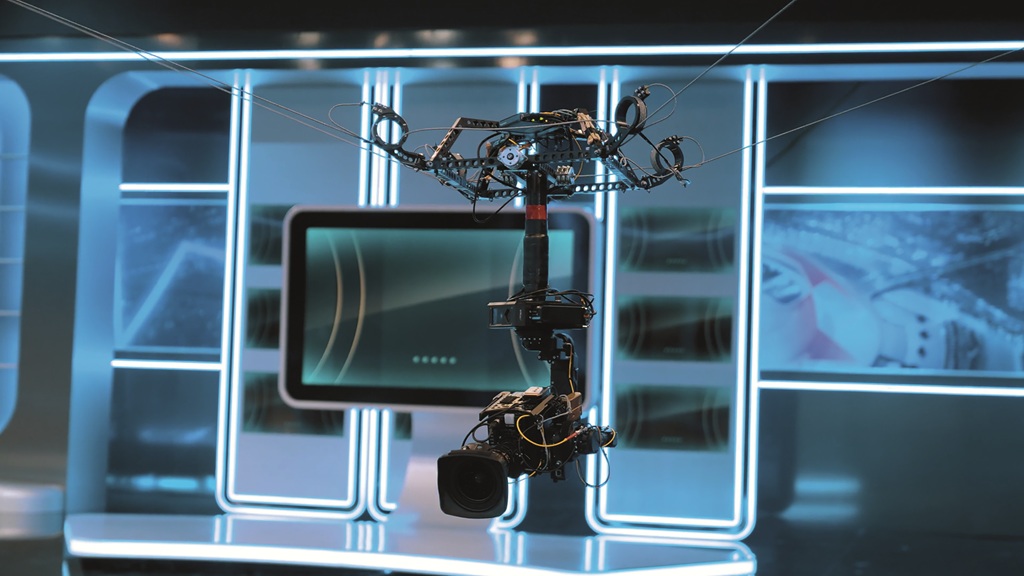

Die Robotik hat sich in enger Verzahnung mit Licht-, Ton- und Medientechnik bereits im Sport-Broadcast und in den Newsrooms etabliert. Als Nächstes wird Kamera-Robotik in der Unternehmenskommunikation Einzug halten. Ein Paradebeispiel dafür ist die RWE AG, einer der vier großen Energieversorger Deutschlands. Sie betreibt an ihrem internationalen Headquarter in Essen ein hochmodernes UHD-VR-Studio – komplett automatisiert und robotisch gesteuert.

Ausgestattet mit Panasonic AW-UE150 PTZ-Kameras, dem KST-CamBot-System und der Reality Engine von Zero Density steht hier ein Studio, das klassische Räume für Pressekonferenzen und Meetings in den Schatten stellt. In den immersiv gestalteten virtuellen Sets interagieren die Sprecher mit animierten Grafiken und Augmented-Reality-Elementen.

Herzstück des Studios ist das KST‑CamBot‑System des deutschen Systemintegrators KST Moschkau. Die in enger Zusammenarbeit mit Panasonic und Zero Density entstandene Lösung kombiniert virtuelle 3D-Umgebungen mit Live-Kamerabildern. Durch Echtzeit-Rendering passen sich virtuelle Objekte dynamisch an die robotischen Kamerabewegungen an – Zuschauer haben den Eindruck, dass Moderatoren oder Sprecher direkt in einer virtuellen Umgebung stehen oder mit virtuellen Elementen interagieren.

Das KST‑CamBot‑System übernimmt komplexe Bewegungsabläufe und führt vordefinierte Fahrten aus. Dank dieser intelligenten Robotik werden aufwendige Kameraschwenks, Perspektivwechsel und dynamische Tracking-Shots möglich – ohne ein großes Kamerateam vor Ort.

Automatisierte robotische Kamerasysteme setzen neue Maßstäbe in der professionellen Videoproduktion. Interne Präsentationen, Live-Schaltungen oder hybride Events lassen sich mit Robotik auf Broadcast-Niveau heben. Für RWE bedeutet das Setup eine visuelle Aufwertung der Unternehmenskommunikation mit einem Produktionsaufwand, der sich in Grenzen hält.

Neben der spektakulären Bildsprache bieten Roboterlösungen für ProAV noch andere Vorteile: Sie reduzieren die Abhängigkeit von großen Kameracrews, erlauben präzise wiederholbare Fahrten und steigern die Produktionssicherheit – insbesondere bei Live-Events. Das Ergebnis: mehr Effizienz, höhere Zuverlässigkeit – und Bilder, die sich ins Gedächtnis brennen.

Kamerarobotik: Präzision trifft Perspektive

Eine Einheitslösung für Roboterkameras in Bewegung gibt es bisher nicht. Anwenderunternehmen haben die Qual der Wahl. Unterschiedliche Veranstaltungsorte stellen unterschiedliche Anforderungen an die Robotik. Während in Nachrichtensendungen oder Unternehmensstudios vor allem Präzision, Wiederholbarkeit und Kompaktheit gefragt sind – etwa durch deckenmontierte Schienen- und Seilkamera-Systeme oder automatisierte PTZ-Kameras (Kameras mit dynamischer Perspektivensteuerung) – steht im Sport- und Eventbereich die Dynamik im Vordergrund.

Dort müssen Roboterkameras schnelle Bewegungen abbilden und mit AR-Elementen oder Live-Grafiken verschmelzen. Durch die Möglichkeit, komplexe Bewegungsabläufe robotischer Systeme vorab zu programmieren, entsteht eine konsistente Inszenierung, die sich mit höchster Genauigkeit beliebig oft wiederholen lässt.

Bei der Wahl eines Robotik-Systems spielen die Platzanforderungen eine zentrale Rolle. Darum gibt es unterschiedliche Ansätze von deckengeführten Seil- oder Schienensystemen wie Spidercam (z.B. Ross Robotics), Track-Cams (z.B. Movicom oder RailCam Robotics), PTZ-Kameras mit Tracking (Panasonic), Lift- oder Teleskopsysteme und nicht zuletzt leichtgewichtige mobile Plattformen, sogenannte Dolly-Systeme (z.B. MRMC Robotic Dolly). Eine Anforderung dabei ist: Roboter-Arme und Seilkamera-Systeme dürfen den Zuschauerfluß nicht behindern und müssen sich nahtlos ins Geschehen einfügen.

Das kabelgeführte Spidercam-System wurde von der österreichischen Spidercam GmbH entwickelt. Seit 2022 gehört die Technologie dem kanadischen Unternehmen Ross Video und ist Teil der Produktlinie Ross Robotics, zusammen mit Systemen wie Furio, CamBot und Vision[Ai]ry.

Das Konzept der Spidercam zieht seine Inspiration aus der Comic- und Filmwelt rund um den Superhelden Spiderman: Vier motorisierte Seilwinden bewegen eine hochstabilisierte Kamera frei im Raum, geführt über vier Zugpunkte und entlang aller dreier Achsen (horizontal, vertikal, diagonal). So entsteht eine nahtlose Rundumsicht, die klassischen Kran- und Drohnenaufnahmen in puncto Beweglichkeit und Präzision deutlich überlegen ist.

Das Setup gilt als betriebssicher, aber Aufbau und Betrieb sind relativ aufwendig. Robotik hin oder her: Am Set sind in der Regel drei Fachkräfte erforderlich. Die Steuerung – Position, Geschwindigkeit, Trajektorien – erfolgt über Beckhoff Embedded-PCs, die mit der TwinCAT-Automatisierungssoftware kommunizieren.

Diese Art Robotik kommt bevorzugt in Arenen, Studios oder Bühnen mit festen Aufhängepunkten zum Einsatz, oft bei Sport-Events, Konzerten und AR-Setups. Die Position der Kamera ist zu jedem Zeitpunkt exakt bekannt. In Deutschland wird die Spidercam unter anderem über spezialisierte Dienstleister angeboten, die Vermietung und technischen Support übernehmen, zum Beispiel die Professional Motion Technology GmbH PMT.

Sky Deutschland demonstriert eindrucksvoll, wie moderne Robotik die Nachrichtenproduktion auf ein neues Niveau hebt. Durch maßgeschneiderte Schienensysteme und robotische Kameras realisiert der Sender dynamische Fahrten, die sich klar von klassischen Produktionen abheben. Bemerkenswert: Trotz eines kleineren Teams sorgt die Automatisierung für höchste Produktionsqualität. Die Montage des SkyDollys an der Studiodecke schafft zusätzliche Flexibilität.

Eindrucksvolle Luftaufnahmen mit einer vergleichbaren Flexibilität liefern frei fliegende Drohnen. Allerdings geht der Einsatz von Drohnen mit einer Reihe von Einschränkungen einher, insbesondere Absturzrisiko, Lärm und limitierter Flugdauer. Positionstracking ist zwar möglich, aber umständlich. Der Einsatz von Drohnen erfordert zudem in der Regel eine Fluggenehmigung und unterliegt auch sonst strengeren regulatorischen Auflagen.

Systeme wie Furio von Ross Video ermöglichen dynamische, fließende Kamerafahrten, die das Publikum förmlich ins Geschehen hineinziehen. Besonders in kleinen Studios schaffen robotische Stative bzw. Podeste sowie deckenmontierte Dolly-Systeme faszinierende Bewegungen – ganz ohne sperrige Bodenschienen. Damit lassen sich selbst in kleinsten Studios fesselnde Kamerabewegungen realisieren.

Die Furio-Produktlinie umfasst motorisierte Dolly-Systeme, vertikale Lifts und präzise Pan-Tilt-Heads – alle steuerbar über das SmartShell-System von Ross Video. Zwar erfordern diese Lösungen eine sorgfältige Planung und etwas Bodenfläche, doch der Zugewinn an kreativen Möglichkeiten ist enorm.

Ein weiterer Innovationsschub kommt durch KI-gestützte Bildanalyse und Automatisierung. Auf Branchenevents wie ISE und InfoComm waren semi-autonome Kamerasysteme zu bestaunen, die mit KI-basierter Gesichts- und Bewegungserkennung arbeiten und auf das Geschehen autonom reagieren, indem sie ihre Position und sonstige Einstellungen eigenständig anpassen.

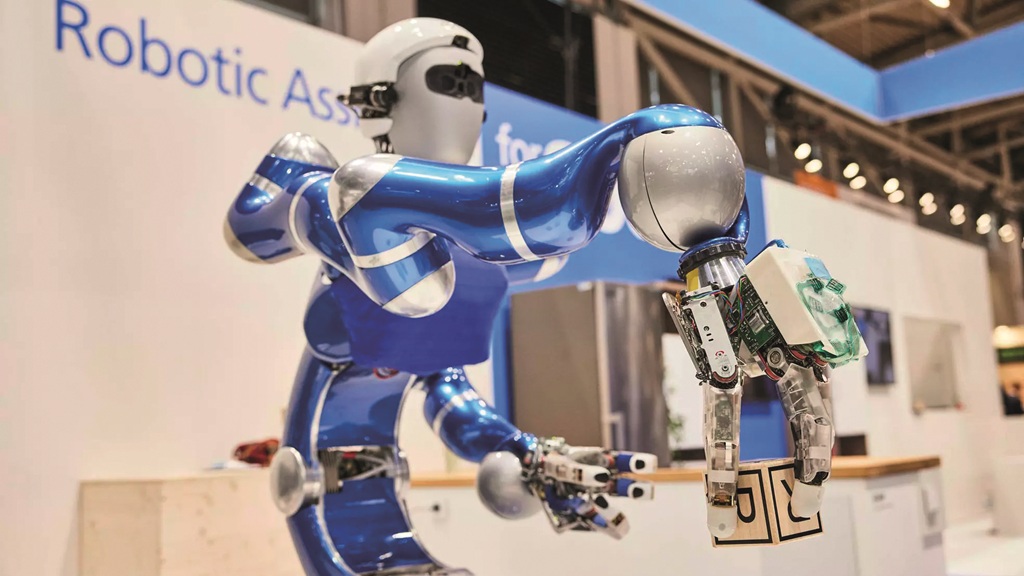

Die humanoiden Roboter kommen

2025 kann als das Jahr des Aufbruchs humanoider Roboter in den ProAV-Sektor bezeichnet werden. Es zeigt sich ein tiefgreifender Wandel in der Art, wie interaktive Räume, Studios und Veranstaltungsorte gestaltet und betrieben werden. Das allerdings soll erst der Anfang sein, wenn es nach maßgeblichen Protagonisten geht: „Wir arbeiten auf einen Tag hin, an dem es Milliarden von Robotern, Hunderte Millionen autonomer Fahrzeuge und Hunderttausende robotergesteuerter Fabriken geben wird“, entwirft Jensen Huang, Mitgründer, Präsident und CEO von NVIDIA, die ganz große Vision vom massenhaften Einsatz cyberphysischer Systeme.

Anbieter wie NEURA Robotics setzen derweil neue Maßstäbe der Vielseitigkeit, die zwar nicht speziell ProAV-Anwendungen adressieren, aber auch und gerade dort ihr Potenzial entfalten. Das Hightech-Unternehmen mit Sitz in Metzingen entwickelt kognitive Robotik, also Maschinen, die sehen, hören, fühlen und aus Erfahrung lernen können. Statt nur Befehle auszuführen, reagieren die NEURA-Roboter eigenständig auf ihre Umgebung. Anfang Juni verdiente sich NEURA auf der Automatica in München große Anerkennung. Mit dem 4NE1 stellte es einen der ersten serienreifen humanoiden Roboter Deutschlands vor.

Der kryptische Name 4NE1 steht für die Vision eines universellen Roboters, der sich in beliebigen Anwendungsszenarien bewährt, sprich: ein Roboter „For Anyone“. 4NE1 kann seine Umgebung selbstständig wahrnehmen, Entscheidungen treffen und aus Erfahrungen lernen – ganz ohne Schutzumhausung. Der patentierte Omnisensor erfasst Menschen und Objekte mit sieben Kameras, während die künstliche Haut Berührungen schon vor dem Kontakt empfindet, was die Sicherheit der Mensch-Roboter-Interaktion erhöht.

NEURA nutzt gleich mehrere Schlüsseltechnologien von NVIDIA. Für die 4NE1-Plattform setzt es auf das Foundation-Model NVIDIA Isaac GR00T. Mit Simulations- und Lernumgebungen wie Isaac Sim und Isaac Lab trainiert es Roboterfähigkeiten virtuell, bevor sie in der realen Welt auf die Probe gestellt werden. Und mit NVIDIAs Plattformen Omniverse und Cosmos erstellt NEURA Robotics realitätsnahe digitale Zwillinge der physischen Realität.

Für die Analyse von Testläufen, Bewegungen und Interaktionen verwenden viele Forschungslabore Adobe Premiere Pro. Diese neue KI-gestützte Media Intelligence erkennt automatisch relevante Szenen, Objekte und bestimmte Bewegungsmuster und ermöglicht ein schnelles Durchsuchen großer Videomengen. So können Entwickler gezielt Fehlerquellen oder Optimierungspotenziale identifizieren, ohne stundenlang Rohmaterial zu sichten.

Mit der Integration von generativer KI – darunter Adobes Firefly-Modell – entstehen in Premiere Pro realistische Simulationen, etwa um zu zeigen, wie ein Roboter auf bestimmte Umwelteinflüsse reagiert oder wie sich verschiedene Greifer-Modelle im Einsatz verhalten. Zudem lassen sich Objekte per KI einfügen oder entfernen, was die Visualisierung von Konzeptstudien oder Prototypen erleichtert. Die Integration von KI und Automatisierung macht Adobe Premiere Pro zu einem leistungsstarken Werkzeug, um Robotikprojekte professionell zu dokumentieren und zu analysieren. NEURAs eigene, international angesehene, offene Robotik-Plattform Neuraverse wiederum ermöglicht es Robotern, voneinander zu lernen und ihre Fähigkeiten miteinander zu teilen.

Momentan sind humanoide Roboter noch eine Aufsehen erregende Kuriosität. Aber realistische Szenarien zeichnen sich bereits ab. Mit humanoiden Robotern wie 4NE1 lassen sich beispielsweise immersive Besucherführungen, Museumsinstallationen oder Erlebnisräume realisieren. Sie könnten auf Regieanweisungen reagieren und als „Co-Hosts“ auftreten. In Konferenzzentren oder Bildungseinrichtungen könnten NEURA-Roboter wie MiPA dank Gestenerkennung, Sprachausgabe und Reaktionsfähigkeit als interaktive Assistenten fungieren – zur Wegführung, für Übersetzungen oder zur Unterstützung von Menschen mit Einschränkungen.

In AR-Szenarien könnten Roboter als physische Schnittstelle zu digitalen Inhalten dienen – zum Beispiel durch Gestensteuerung, haptisches Feedback oder Kontextinteraktion. Denkbar sind auch gemischte Realitäten, in denen ein humanoider Roboter mit einem VR-Avatar synchronisiert wird – für Bildung, Therapie, Telepräsenz oder Entertainment. Mit seiner Tragkraft von 100 Kilogramm und der Fähigkeit zur punktgenauen Bewegung ist der 4NE1 zudem ein echter Schwerarbeiter: Ob das präzise Positionieren von AV-Equipment oder das Steuern komplexer Kamerafahrten – dieser Allrounder meistert solche anspruchsvollen Aufgaben mit Leichtigkeit.

Parallel dazu schlägt die offene Robotik-Plattform Neuraverse ein neues Kapitel für kreative Köpfe auf: Damit lassen sich AV-Systeme über APIs integrieren – etwa zur Steuerung von Displays, Audioquellen oder Raumautomation. Externe Entwickler erhalten damit die Chance, maßgeschneiderte ProAV-Anwendungen umzusetzen.

NEURA Robotics hat eine strategische Kooperation mit SAP und NVIDIA geschlossen, mit dem Ziel, gemeinsam Physical AI Agents zu entwickeln. Gemeint sind kognitive Roboter, also cyberphysische Systeme, die sowohl denken als auch mechanisch handeln können.

Eine Handvoll Anbieter

Im deutschen ProAV-Markt behauptet sich bislang nur eine Handvoll Robotik-Anbieter (siehe Kasten unten. Einige Neuzugänge wagen gerade den Markteintritt aus angrenzenden Feldern und bringen ihr praxiserprobtes Automatisierungs-Know-how mit – – darunter etablierte Anbieter wie KUKA aus Augsburg, Stäubli aus Bayreuth und die in Zürich beheimatete ABB Robotics. Vielversprechende Potenziale entstehen durch die Übertragung industrieller Automatisierung auf ProAV-Anwendungen.

Ein Beispiel: Die Kooperation zwischen dem Münchner Robotik-Unicorn Agile Robots und voraus robotik aus Hannover, einem Spezialisten für industrielle Robotik-Software, lässt Hardware und intelligente Steuerung zusammenwachsen. Gemeinsam entwickeln sie die Steuerungssoftware für den Cobot Yu5 Industrial, inklusive Bildverarbeitung, Interaktionssteuerung und KI-Technologien. Der Cobot ist dank menschenähnlicher Sensorik auch für interaktive Umgebungen in ProAV-Szenarien geeignet – etwa für Showrooms, interaktive Ausstellungen, Studioautomation oder Messeanwendungen. Konkrete Use Cases gibt es dafür im Moment aber noch nicht. Auch 4NE1 ist gerade erst in der Phase der Markteinführung.

Fazit & Ausblick

Wohin die Reise geht, zeigte sich spektakulär zuletzt Mitte Juni auf der InfoComm in Florida. Dort hatten humanoide Roboter starke Auftritte. Besucher konnten hinter die Kulissen spektakulärer Live-Inszenierungen blicken und beobachten, wie KI-gesteuerte Assistenten künftig in AV-Workflows integriert werden, etwa für Kamera-Tracking, Bühnenautomation oder interaktive Besucherführung. Beispielhaft sichtbar werden solche innovativen Ansätze etwa beim Cirque du Soleil: Durch KI-gesteuerte Bühnentechnik, vollautomatische Hebesysteme und bewegliche AV-Elemente entsteht ein immersives Erlebnis, das klassische Showtechnik in den Schatten stellt.

Einige Beispiele: Unitree Robotics präsentierte gemeinsam mit dem Robotics Club der UCF den extrem gelenkigen Humanoiden G1. UBTECH ließ Walker für Audi auftreten – und der Name war Programm. Agility Robotics zeigte den schlanken Logistikroboter Digit im As-a-Service-Modell. Apptronik demonstrierte Apollo, PAL Robotics war mit REEM-C dabei. 1X Technologies präsentierte EVE und NEO, Engineered Arts den realistisch gestalteten Ameca. Der freundliche Pepper von RobotLAB lockerte die Stimmung, während BroBot die Innovationsfahne hochhielt.

ProAV steht insgesamt zwar erst am Beginn der Robotik-Ära – und doch öffnen sich schon jetzt faszinierende Spielräume für die nächste Generation von Bühnen- und Medientechnik. Veranstaltungen der Industrie sind aktuell geprägt vom klaren Trend zur KI-gestützten Robotisierung. Elemente der ProAV-Produktion verschmelzen immer stärker zu einem intelligenten Gesamtwerkzeug, das Effizienz mit kreativer Freiheit unter einen Hut bringt.

Im ProAV-Bereich ist Robotik allerdings noch längst keine Einheitslösung von der Stange; sie will vielmehr auf den jeweiligen Anwendungsfall abgestimmt werden. Ob automatisierte Kamerafahrten, humanoide Service-Roboter oder Mechatronik in Sicherheit und Überwachung: Die Herausforderung liegt darin, diese Technologien möglichst geschmeidig – und damit nicht-disruptiv – in bestehende Infrastrukturen zu integrieren. Ziel ist die Kombination von intelligenter Robotik, maschinellem Lernen und vernetzten Steuerungssystemen in einem fein abgestimmten Zusammenspiel multisensorischer Effekte.

Übersicht: Anbieter für ProAV-Robotik

Robotik-Unternehmen der DACH-Region setzen mit ihren innovativen Lösungen Maßstäbe in der ProAV-Branche. Hier eine Auswahl:

RoboStage (Berlin): High-End-Bühnenroboter liefern fließende Kamerabewegungen und synchronisierte Lichtchoreografien, hauptsächlich für Livestreams und Eventproduktionen.

Verity (Zürich): Weltmarktführer. Seine autonomen Indoor-Drohnen für Licht- und Kamerachoreografien waren unter anderem im Einsatz bei Shows von Céline Dion und Metallica.

Wegener Automation (NRW): Modulare Steuerungsplattformen orchestrieren sekundenschnelle Szenenwechsel in Theater- und Messeumgebungen – von Aufbau bis Dunkelphase.

Franka Robotics und Agile Robots (München): Feinfühlige Cobots interagieren direkt mit Besuchern oder bewegen Exponate in Museen und Showrooms, um spielerische Touchpoints zu schaffen.

BÄR Automation (Mellrichstadt): Robuste Bewegungsplattformen und Kameraschwenker schaffen die richtige Perspektive in Messeständen und digitalen Inszenierungen.

Econocom/ICT AG (Frankfurt/Köln): Integratoren für Digital Signage und LED-Wall-Steuerung binden AV-Roboter nahtlos in immersive Medienräume ein.

Verity Studios (Zürich, Schweiz): Choreografien von Drohnen-Schwärmen für Live-Events und immersive AV-Inszenierungen mit Integration in Show-Control-Systeme zur Echtzeit-Flugsteuerung.